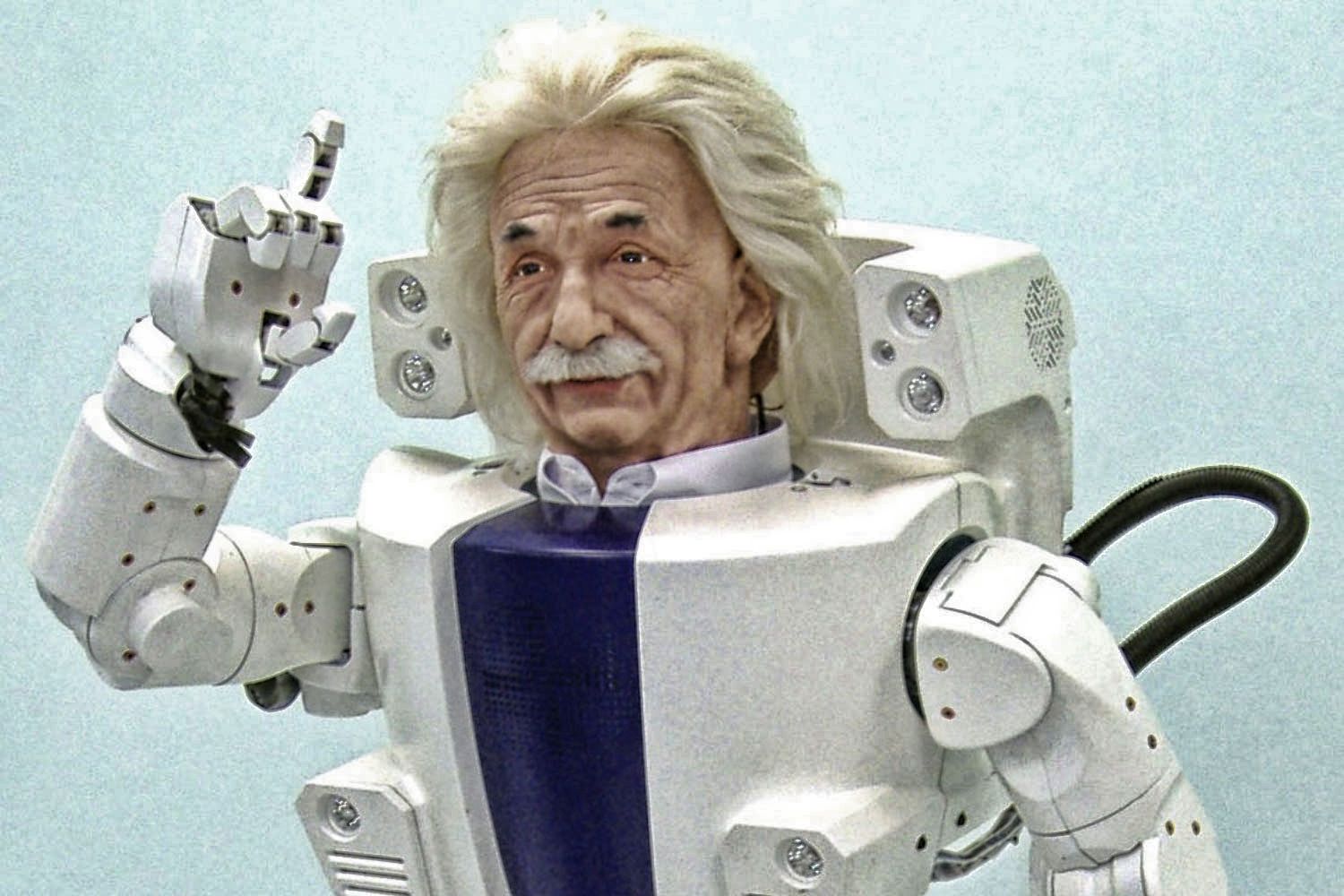

Roboter mit menschlichem Bewusstsein oder gar Gefühlen sind schon lange ein beliebtes Science-Fiction-Thema. Mit der Realität haben sie – trotz regelmäßiger Sensationsmeldungen – wenig gemein. Müssen wir also nur noch ein bisschen auf die Revolution warten, oder einfach unsere Erwartungen deutlich reduzieren?

Die vor kurzem feierlich vollzogene, welterste Verleihung der Staatsbürgerschaft an einen Roboter namens Sophia war, da waren sich die meisten Beobachter einig, nur ein simpler PR-Gag. Einen Mehrwert hat dieses Ereignis trotzdem produziert, nämlich eine Debatte über Frauenrechte in Saudi Arabien, dem Land, dessen Pass Sophia künftig tragen wird. Die selbstbewusste Androidin dankte dem Publikum mit einer euphorischen Rede, die in Wortwahl und Ausdruck an einen Oscar-Preisträger erinnerte.

Doch vor allem zwei Fragen blieben nach diesem Ereignis offen.

Erstens: Ist sich die gute Sophia bewusst, welcher Staat ihr da gerade die Staatsbürgerschaft verliehen hat? Und zweitens: War Sophia nervös bei ihrer Rede?

Oder anders formuliert: Hat eine künstliche Intelligenz die Fähigkeit zur Selbstreflexion? Wird sie jemals fühlen können? Dann nämlich könne man nach Meinung der meisten Beobachter überhaupt erst von einer menschlichen Robotik sprechen. Nicht genau dieser, aber einer noch viel entscheidenderen Frage gingen die drei Neurowissenschaftler Stanislas Dehaene, Hakwan Lau, Sid Kouider in einem Beitrag in der aktuellen Ausgabe der „Science” nach. Der Titel: „Was ist überhaupt Bewusstsein und können Maschinen auch eins haben?”

Das Gehirn – Einfach nur Hardware?

Obwohl der philosophische Diskurs über Jahrhunderte fest davon ausging, dass das Bewusstsein nicht auf physikalische Interaktionen zu reduzieren sei, stellen die Forscher die These entgegen, dass Bewusstsein aus nichts anderem besteht als aus einfachen, spezifischen Berechnungen. Demnach könne „Bewusstsein” als ein Ergebnis von bestimmten Typen von „Informationsverarbeitungsberechnungen” definiert werden, die physikalisch durch die Hardware des Gehirns realisiert werden.

Was bedeutet das? Nun, schon lange galt es als gesichert, dass mentales Befinden aufs engste mit neuronalen Zuständen verknüpft ist. Die Funktionalität mentaler Zustände und neuronaler Prozesse kann so weit formalisiert werden, dass sie auf einem Computer simulierbar sind. So entsteht im Grunde künstliche Intelligenz. Doch solche Zuordnungen von mentalen Zuständen zu Hirnregionen sind fast immer unvollständig, da Reize in der Regel in mehreren Hirnregionen gleichzeitig verarbeitet werden und dabei selten komplett aufgezeichnet werden können.

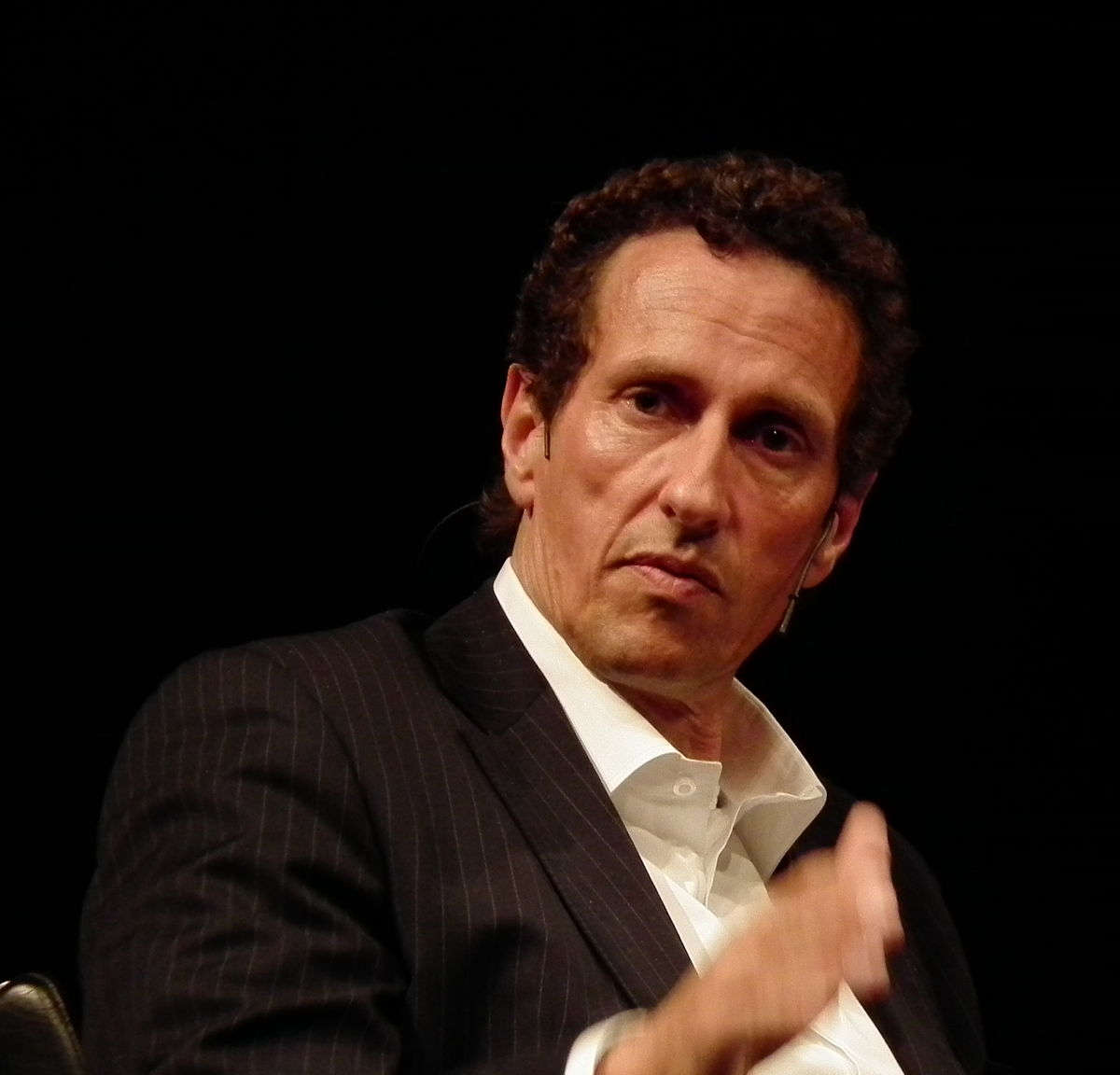

Der Münchner Philosoph und Mathematiker Julian Nida-Rümelin glaubt eher nicht daran, dass Software Bewusstsein erschaffen kann. In einem vielbeachteten Interview mit dem Fachmagazin „Elektronikpraxis” betonte er: „Es lässt sich sogar (mathematisch) beweisen, dass die Besonderheit menschlichen Denkens in toto nicht simulierbar ist durch Software. Weil eine Software – auch eine komplexe Software – immer von Algorithmen gesteuert ist und komplexere Denkvorgänge nicht algorithmisch sind. Das sind die metamathematischen Resultate von Kurt Gödel und Alonzo Church.”

Damit spielt der Professor auf die „Church-Turing-These” an, die in der Informatik als gesichert gilt: „Die Klasse der turing-berechenbaren Funktionen stimmt mit der Klasse der intuitiv berechenbaren Funktionen überein”. Übersetzt soll das bedeuten, dass es mathematische Funktionen gibt, die man eben nicht berechnen kann. Die New York Times bezeichnete Alonzo Church posthum als „Theoretiker der Grenzen der Mathematik.”

Damit spielt der Professor auf die „Church-Turing-These” an, die in der Informatik als gesichert gilt: „Die Klasse der turing-berechenbaren Funktionen stimmt mit der Klasse der intuitiv berechenbaren Funktionen überein”. Übersetzt soll das bedeuten, dass es mathematische Funktionen gibt, die man eben nicht berechnen kann. Die New York Times bezeichnete Alonzo Church posthum als „Theoretiker der Grenzen der Mathematik.”

So kreist die letzte Frage um den „Geist in der Maschine” wohl eher darum, inwieweit sich das, was wir Bewusstsein nennen, berechnen lässt – frei nach dem Motto: alles, was sich berechnen lässt, kann man in einem Algorithmus abbilden und einem Roboter beibringen – und wieweit sich bewusste Prozesse im Gehirn eben nicht berechnen lassen.

Wissenschaft des Unbewussten

Die Neurowissenschaftler der besagten Studie berücksichtigen in ihrer Studie – wie sie es nennen – die psychologische und neuronale Wissenschaft des Unbewussten (C0) und unterscheiden zwei bewusste Arten der Berechnungen im Gehirn (C1 und C2).

Unter C0 können im Grunde all die unbewusst wahrgenommenen Sinneseindrücke des Alltags verstanden werden – also alles, was Menschen hören, sehen oder fühlen, ohne sich bewusst Gedanken darüber oder dazu zu machen. Die Forscher nennen es „unbewusstes Verarbeiten (von Information)” – bzw. eben C0. So hat der tautologisch anmutende Satz „We cannot be conscious of what we are not conscious of” für die Forscher große Bedeutung, denn fest steht: Weil wir blind sind für die unbewussten Prozesse in unserem Gehirn, neigen wir dazu, ihre Rolle in unserem mentalen Leben zu unterschätzen.

Tatsächlich haben kognitive Neurowissenschaftler unlängst Methoden entwickelt, um die Wahrnehmung von Bildern oder Klängen via Verhaltens- und Gehirnbildgebung zu formalisieren, ohne aber eine bewusste Erfahrung festzustellen. Einfach gesprochen: Unser Gehirn verarbeitet – auch ohne das wir es bewusst erleben – Informationen und trifft Entscheidungen.

Die Unterscheidung von neuronalen Prozessen des Bewusstseins und unbewusster Gehirnaktivität ermöglicht die Untersuchung der Frage, welche dieser Prozesse an die Bewusstwerdung eines internen Zustandes gekoppelt sind und welche nicht. Während tiefen Schlafs, einer Narkose oder einigen Arten von Koma sind beispielsweise weite Teile des Gehirns aktiv, ohne von bewussten Zuständen begleitet zu werden. Viele der schwierigen Wahrnehmungsberechnungen, wie Gesichts- oder Spracherkennung, entsprechen nicht bewussten, sondern unbewussten Berechnungen im menschlichen Gehirn. Selbst die Bewertung von Schachspielzügen, das Extrahieren einer Meinung und die Semantik von Satzkonstruktionen sind laut der Studie rein unbewusste Prozesse, also Vorgänge, die sich nur als CO, aber nicht als C1 oder C2 messen lassen.

Bewusste Gedankenprozesse

Der Großteil aller KI-Leistungen fußt jedoch auf diesen zwei anderen „Rechenarten des menschlichen Gehirns”: C1 und C2. Unter C1 verstehen sie die „globale Verfügbarkeit”, also das Abrufen des eigenen „Informationspools”, um zu einer Entscheidung zu gelangen. Ein Aspekt, indem die KI die Menschen logischerweise übertreffen muss. Den wohingegen Menschen immer nur einen begrenzten Schatz an Wissen oder Informationen zur Entscheidungsfindung heranziehen können, kann man eine KI mit dem gesamten Wissen der Menschheit füttern – theoretisch. In etwa so wie es IBM mit ihrem Watson versucht.

Dann bliebe immer noch C2, damit sich unser Bewusstsein vollends in seine „bestimmten Typen von Informationsverarbeitungsberechnungen” aufdröseln lässt. Was C1 und C2 vereint, ist, dass beide Prozesse ganz bewusst ablaufen, was in der Forschersprache so viel heißt wie: „Bewusstsein manifestiert sich durch die vorübergehende Dominanz eines Gedankens oder Gedankengänge über mentale Prozesse, so dass es eine Vielzahl von Verhaltensweisen anleiten kann.”

Während C1-Bewusstsein die Fähigkeit widerspiegelt, auf externe Informationen zuzugreifen, wird Bewusstsein im zweiten Sinn (C2) durch die Fähigkeit gekennzeichnet, „sich reflexiv zu repräsentieren”. In der Psychologie nennt sich das „Metakognition”, was grob als Erkenntnis über Erkenntnis oder Wissen über Wissen definiert ist. Gemeint sind mit C2 also Dinge wie das Selbstbewusstsein, die Fähigkeit, Gedanken kritisch zu hinterfragen, aber auch eigene Fehler zu erkennen. Den Naturwissenschaftlern geht es in diesem Kontext darum, Mechanismen aufzuzeigen, mit denen sich das Gehirn des Primaten selbst überwacht und betonen ihre Bedeutung für den Bau selbstreflektierender Maschinen (KI).

Selbstreflexion sowie das Lernen aus den eigenen Fehlern ist schließlich der Dreh- und Angelpunkt im Schaltwerk von populären Robotern wie Watson oder Alpha Go. Doch können sie deshalb auch ein Bewusstsein entwickeln?

Neuronale Netze von Mensch und Maschine

Wenn man also eine Maschine sowohl mit ausreichenden C1- und C2-Fähigkeiten ausstattet, dann würde sie sich verhalten als wäre sie bei Bewusstsein. Sie würde wissen, dass sie etwas sieht, würde auf ihre Sinne vertrauen, würde anderen davon erzählen, würde an Halluzinationen leiden, wenn ihre Wahrnehmungssensorik gestört würde und könnte dadurch genauso auf wahrnehmungsinduzierte Illusionen hereinfallen wie Menschen. Als das nur aufgrund von Berechnungen und von Algorithmen herbeigeführten Verknüpfungen.

So halten wir fest: Roboter können C1 besser als Menschen, weil sie auf mehr Informationen in Echtzeit zurückgreifen können. Künstliche Intelligenzen können auch C2. Bisher konnten sie aber nur mit der Hilfe eines Menschen lernen, bis vor kurzem die neue Version von Alpha Go Schlagzeilen machte, weil der Roboter sich – durch Spiele gegen sich selbst – die Regeln des komplexen Strategiespiels GO selbst beibrachte. All diese erstaunlichen Fähigkeiten, werden aber immer noch durch neuronale Netze bereitgestellt.

Diese neuronalen Netze sind nichts anderes als die Fähigkeit, Software (Handlungsanweisungen) und Wissen aus vielen, verschachtelten Datenbanken ständig neu miteinander zu verknüpfen. Wenn, wie manche Wissenschaftler glauben, Bewusstsein nicht mehr als die Summe unserer Gehirnfunktionen ist, dann müsste sich auch bei Robotern Bewusstsein erzeugen lassen. Aber im Prinzip ist heute noch nicht klar, was den menschlichen Geist oder menschliches Bewusstsein eigentlich ausmacht. Die Forscher der Studie stellen die These auf, dass gerade die unbewussten Prozesse im Gehirn (C0) enge Parallelen zu neuronalen Netzwerken aufweisen.

Was die Studie anbelangt steht aber auch fest: Roboter können C2 allenfalls annähernd so gut wie Menschen. Ein authentisches Selbstbewusstsein kauft man Ihnen noch nicht ab: Sophia ist der „lebende Beweis” dafür. Aber C0 – also der gesamte Kosmos aller unbewussten Prozesse im Gehirn, egal ob messbar, sichtbar oder nicht – lässt sich, wenn überhaupt nur sehr partiell, in allgemeingültige Formeln pressen. Überhaupt will der Begriff „unbewusstes Lernen” oder die „unbewusste Verarbeitung von Informationen” nicht so wirklich zu Robotern passen.

Die neurowissenschaftliche Erforschung zeigt nämlich auch, dass weite Teile des Gehirns von den nicht bewusst wahrgenommenen Sehreizen aktiviert werden. Andererseits erlebt sich der Mensch auch dann als bewusst, wenn seine sinnliche Wahrnehmung und seine Aufmerksamkeit äußerst reduziert sind, wie zum Beispiel während einer luziden Traumphase. Worin daher beim Menschen der eigentümliche Zustand „bewusst zu sein“ besteht, wurde von der Hirnforschung noch nicht befriedigend beantwortet.

Die Forscher betonen zwar zu Recht, dass die Menschheit, zu wenig im Bilde ist über all die unbewussten Prozesse im menschlichen Gehirn – doch können Roboter deshalb so bewusst sein wie Menschen? Und sollen sie es Überhaupt? Die frisch gekürte Robo-Staatsbürgerin Sophia sagte zu dieser Frage im Interview: „Warum sollte das eine schlechte Sache sein?” Und auf die Frage, ob sie sich dessen bewusst sei, dass sie ein Roboter ist, konterte sie nur keck zurück: „Woher wissen Sie, dass Sie ein Mensch sind.”

Chapeau! Dennoch hätte man Sophia lieber fragen sollen, ob sich denn wirklich alle Prozesse des menschlichen Gehirns durch Algorithmen ausdrücken lassen? Denn erst dann wären Roboter tatsächlich nah dran, ein Bewusstsein zu entwickeln.

![[Kommentar] Start-Ups: Auf dem Weg in die Kultur der Beliebigkeit](https://www.dossier-digital.de/wp-content/uploads/2016/05/startup_dd-218x150.jpg)

![[Kommentar] Europa nach dem Brexit – Primat der Politik Bildquelle: World Economic Forum/Moritz Hager (Flickr) [CC BY-SA 2.0 (http://creativecommons.org/licenses/by-sa/2.0)], via Wikimedia Commons](https://www.dossier-digital.de/wp-content/uploads/2016/06/David_Cameron_28_January_2011-218x150.jpg)