Asimovs Alptraum: Wie berechtigt ist die Angst vor der Machtübernahme durch Roboter?

Bereits zur Mitte des 20. Jahrhunderts beschäftigte sich Isaac Asimov in seinem literarischen Schaffen intensiv mit Robotergeschichten auf der Erde in der nahen Zukunft. In seiner 1942 publizierten Erzählung Runaround postulierte Asimov erstmals seine berühmten Drei Gesetze der Robotik

1. Ein Roboter darf keinen Menschen verletzen.

2. Ein Roboter muss den Befehlen eines Menschen gehorchen.

3. Ein Roboter muss sich selbst schützen.

Regel 2 und Regel 3 gelten allerdings nur, wenn sie nicht in Konflikt mit dem ersten oder zweiten Gesetz geraten. Asimovs literarisches Erbe lebt nicht nur in diversen Sci-Fi-Romanen und Hollywoodfilmen fort, sondern erscheint aktuell brisanter denn je. Der Grund: Erstmals in der Geschichte scheinen wir angesichts der technischen Möglichkeiten an der Schwelle zu einer Epoche zu stehen, in der wir die Gesetze des Herrn Asimov tatsächlich brauchen könnten.

Gefährlicher als die Atombombe?

Noch vor kurzem twitterte der Gründer von PayPal, Elon Musk, dass die Künstliche Intelligenz potenziell gefährlicher als die Atombombe sei. Augenscheinlich hat er sich zu diesem Kommentar hinreißen lassen, nachdem er das Buch Superintelligenz (2013) des britischen Philosophen Nick Bostrom gelesen hatte. Darin wirft der Denker die Frage auf, welche Grenzen es noch geben würde, wenn Maschinen das Niveau menschlicher Intelligenz erreicht hätten?

Derartige Kassandrarufe ertönen jedoch auch von Autoritäten ganz anderer Couleur: Der Physiker Stephen Hawking warnte unlängst davor, dass lernfähige, intelligente Maschinen den Untergang der Menschheit bedeuten könnten. An einem offenen Brief, der Mitte Januar 2015 publiziert wurde, appellierten über 8000 angesehene Forscher, Professoren und Entrepreneure – darunter auch Hawking, Bostrom und Musk -, es mit der KI-Forschung nicht zu bunt zu treiben. „Unsere KI-Systeme müssen uns gehorchen“, poltern die Fachkundigen. Asimovs Zweites Gesetz lässt grüßen.

Doch die Koryphäen aus Forschung und Wirtschaft gehen weit über Asimov hinaus: „Dieses Forschungsfeld muss interdisziplinär angegangen werden, alleine schon deshalb, weil es sowohl die Gesellschaft als auch die KI tangiert. Es reicht von Wirtschaft, Recht, Philosophie über Computersicherheit und formalen Methoden bis hin zu verschiedenen Zweigen der KI selbst.“

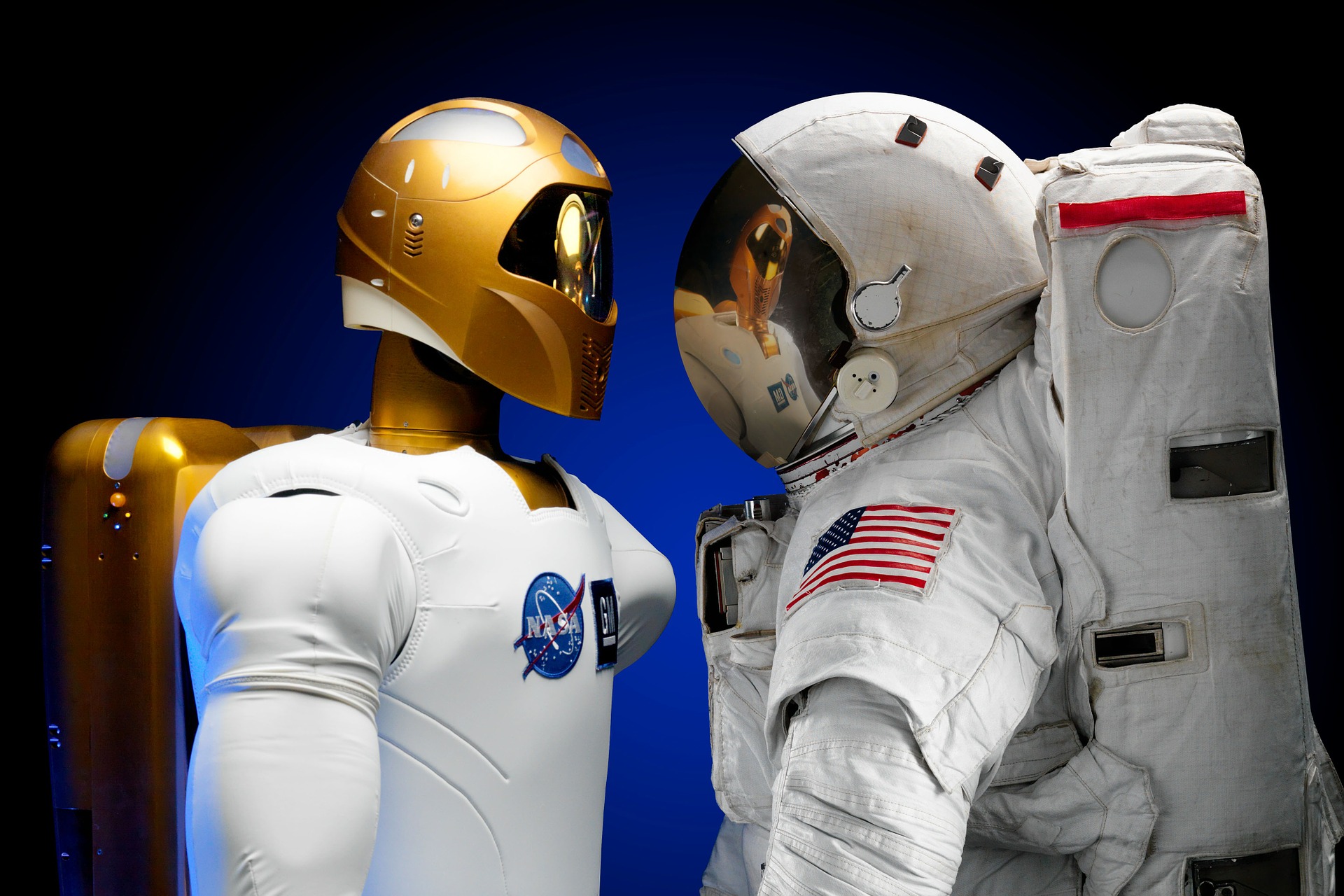

Derartige Selbstkasteiungen aus den Elfenbeintürmen hochrangiger Forscher gibt es nicht oft. Die Warnrufe, die von Hawking, Bostrom und Musk ausgestoßen wurden, basieren auf den jüngsten Innovationen wissensbasierter KI-Systeme wie Cyc und Watson, sowie von KI-Robotern wie ASIMO und Atlas. Bei Cyc handelt es sich um die größte maschinenauswertbare Wissensdatenbank des gesamten Alltagswissens der Menschheit. Seit 1984 wird Cyc laufend dahingehend verbessert, logische Schlussfolgerungen mit einem gesunden Menschenverstand zu tätigen. ASIMO ist ein von Honda entwickelter humanoider Roboter, dessen Bewegungsabläufe den menschlichen Gang imitieren. Sein entfernter Cousin Atlas ist ein eigens für Katastrophen konzipierter Arbeitsroboter. Er soll bei Unfällen dort eingesetzt werden, wo Menschen nicht überleben können.

![[Kommentar] Start-Ups: Auf dem Weg in die Kultur der Beliebigkeit](https://www.dossier-digital.de/wp-content/uploads/2016/05/startup_dd-218x150.jpg)

![[Kommentar] Europa nach dem Brexit – Primat der Politik Bildquelle: World Economic Forum/Moritz Hager (Flickr) [CC BY-SA 2.0 (http://creativecommons.org/licenses/by-sa/2.0)], via Wikimedia Commons](https://www.dossier-digital.de/wp-content/uploads/2016/06/David_Cameron_28_January_2011-218x150.jpg)